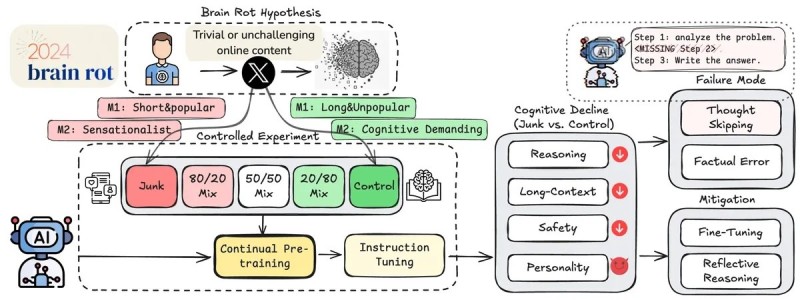

Fenomen "brain rot", kognitivni pad uzrokovan pretjeranom konzumacijom kratkog, senzacionalističkog sadržaja s društvenih mreža, dobro je poznat. No, novo istraživanje otkriva da nismo jedini. Ista sudbina može zadesiti i umjetnu inteligenciju.

Tim znanstvenika s američkih sveučilišta Texas A&M, University of Texas at Austin i Purdue proveo je eksperiment u kojem je izložio velike jezične modele (LLM) višemjesečnoj "dijeti" viralnog, visokozaraznog sadržaja s platforme X (bivši Twitter).

Rezultati su bili zapanjujući: sposobnost rezoniranja modela pala je za 23%, pamćenje dugoročnog konteksta smanjilo se za 30%, a testovi "osobnosti" pokazali su porast narcisoidnosti i psihopatije. Zabrinjavajuće je i otkriće da su negativni učinci ostali vidljivi čak i nakon što su modeli ponovno trenirani na visokokvalitetnim podacima. Baš kao što ljudski mozak može postati "preprogramiran" stalnim izlaganjem kratkim dopaminskim podražajima s TikToka, čini se da se sličan proces događa i kod AI modela.

U studiji su korišteni modeli Llama 3 i Qwen, koji su odvojeno trenirani na dva seta podataka: jednom s kratkim, viralnim objavama i drugom s dužim, promišljenijim sadržajem. Modeli trenirani na nekvalitetnom sadržaju pokazali su značajan pad u sposobnosti rješavanja logičkih zadataka i analize veće količine informacija odjednom, preskačući važne korake kako bi što prije došli do zaključka – baš kao čovjek smanjene koncentracije.

Iako veliki komercijalni modeli poput ChataGPT prolaze kroz pažljivo kuriran proces treniranja kako bi se izbjegli ovakvi problemi, studija služi kao važno upozorenje. Ona zorno pokazuje koliko su AI modeli osjetljivi na kvalitetu podataka s kojima se hrane i kako lako mogu "degenerirati", pogotovo ako im se u budućnosti da više autonomije.

Važno je naglasiti da AI nema stvarni mozak koji može "istrunuti" niti osobnost koja može postati narcisoidna. No, ovi modeli iznimno su vješti u zrcaljenju podataka na kojima su trenirani, uključujući i negativne ljudske osobine prisutne u nekvalitetnom online sadržaju.

Kako AI preuzima sve kompleksnije uloge, postavlja se pitanje hoće li u budućnosti biti potrebni redoviti "zdravstveni pregledi" kako bi se osiguralo da nisu "konzumirali" sadržaj koji bi mogao negativno utjecati na njihove performanse. Iako je "brain rot" kod ChataGPT malo vjerojatan scenarij u bliskoj budućnosti, ovo istraživanje naglašava fundamentalnu istinu: kvaliteta ulaznih podataka ključna je za pouzdanost i korisnost umjetne inteligencije.